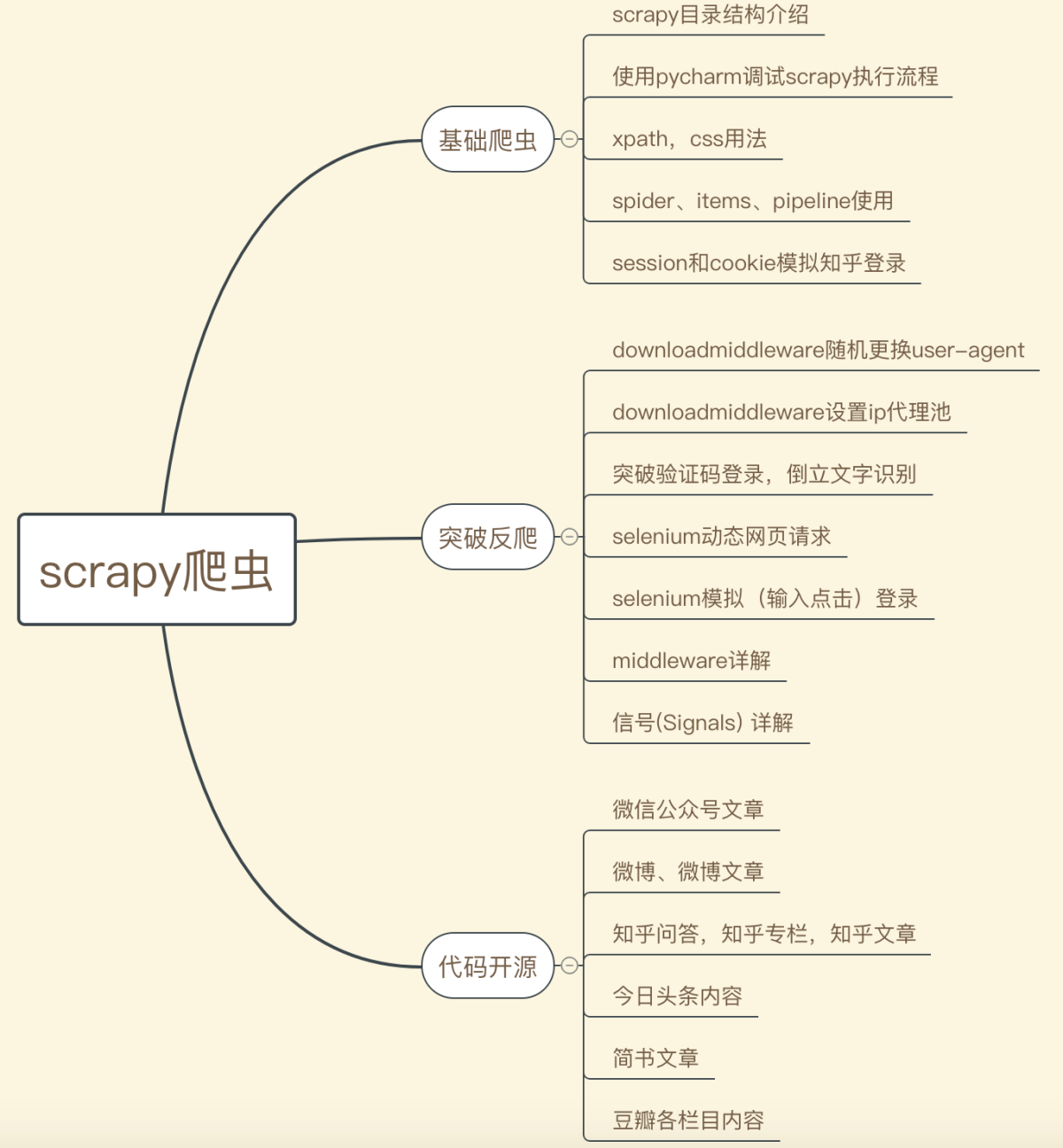

Scrapy是一个基于Python的开源网络爬虫框架,具有高效率、易扩展、易维护等特点,常用于大规模数据抓取。以下是利用Scrapy进行爬虫开发的指南清单:

Scrapy是一个基于Python的开源网络爬虫框架,具有高效率、易扩展、易维护等特点,常用于大规模数据抓取。以下是利用Scrapy进行爬虫开发的指南清单:

安装Scrapy

首先需要安装Scrapy,可以使用pip命令进行安装:pip install scrapy

创建Scrapy项目

使用命令行工具运行以下命令,创建一个新的Scrapy项目:scrapy startproject project_name

定义数据模型

在Scrapy中,需要先定义数据模型,即要抓取的数据结构,并存储在数据库或文件中。可以使用Scrapy的Item机制来定义数据模型,类似于Django的Model。定义好Item后,需要编写Spider来提取和保存数据。

编写Spider

Spider是Scrapy中用于爬取网页的核心组件,根据指定的网站和规则,自动地从网页上抓取信息。需要编写Spider来提取和保存数据。可以使用XPath或CSS选择器来定位和提取所需的数据。

配置Downloader Middleware

Downloader Middleware是Scrapy中的下载中间件,可以对网页进行预处理或后处理。例如,可以添加随机User-Agent、IP代理池等功能,防止被屏蔽或反爬虫。

配置Pipeline

Pipeline是Scrapy中用于数据处理和存储的组件,可以将数据存储到数据库、文件中。可以配置多个Pipeline组件,依次处理数据并保存。

启动Scrapy爬虫

使用命令行工具运行以下命令,启动Scrapy爬虫:scrapy crawl spider_name

调试和优化

在开发过程中需要进行调试和优化,可以使用Scrapy提供的调试功能和日志输出功能。同时也需要关注网页的反爬虫机制,避免被屏蔽或封IP。

以上就是利用Scrapy进行爬虫开发的指南清单,希望能对你有所帮助。